Imagina un mundo donde las computadoras puedan aprender y adaptarse por sí mismas. Ya no estarán limitadas a hacer solo lo que les programamos, las máquinas podrán entender, analizar e incluso predecir cómo se comportan las personas. Esto no es solo un sueño; es una realidad hacia la que nos estamos moviendo rápidamente.

En el mundo lleno de información de hoy, la cantidad de datos puede ser abrumadora. Aunque es fácil recopilar datos, el verdadero desafío es encontrar información útil de toda esa información. Aquí es donde entra el aprendizaje automático.

¿Qué es el aprendizaje automático?

El aprendizaje automático es una parte de la inteligencia artificial que se centra en crear algoritmos que puedan aprender de los datos. Usando datos pasados, pueden predecir resultados futuros, dando a las máquinas una forma más inteligente de analizar grandes cantidades de información y descubrir conexiones ocultas que los humanos podrían pasar por alto.

Varios herramientas de aprendizaje automático ayudan a los desarrolladores a construir y desplegar sistemas inteligentes. Estas herramientas permiten a las empresas adivinar qué productos es más probable que compren los clientes y qué contenido en línea disfrutarán.

Un uso común del aprendizaje automático es en los sistemas de recomendación. Grandes empresas como Google, Netflix y Amazon utilizan estos sistemas para aprender sobre las preferencias de los usuarios, ayudándoles a ofrecer sugerencias personalizadas de productos y servicios.

Historia del aprendizaje automático

El aprendizaje automático ha existido durante bastante tiempo, y es evidente en la forma en que nos referimos a las computadoras hoy en día: "máquinas" es un término que se ha vuelto menos común.

A continuación, se presenta un breve resumen de la evolución del aprendizaje automático, trazando su viaje desde su inicio hasta su aplicación generalizada.

- Antes de 1920: Thomas Bayes, Andrey Markov, Adrien-Marie Legendre y otros matemáticos aclamados sentaron las bases necesarias para las técnicas fundamentales del aprendizaje automático.

- 1943: El primer modelo matemático de redes neuronales se presenta en un artículo científico por Walter Pitts y Warren McCulloch.

- 1949: Se publica "The Organization of Behavior", un libro de Donald Hebb. Este libro explora cómo el comportamiento se relaciona con la actividad cerebral y las redes neuronales.

- 1950: Alan Turing intenta describir la IA y se pregunta si las máquinas tienen la capacidad de aprender.

- 1951: Marvin Minsky y Dean Edmonds construyeron la primera red neuronal artificial.

- 1956: John McCarthy, Marvin Minsky, Nathaniel Rochester y Claude Shannon organizaron el Taller de Dartmouth. El evento a menudo se refiere como el "lugar de nacimiento de la IA", y el término inteligencia artificial fue acuñado en el mismo evento.

Nota: Arthur Samuel es considerado el padre del aprendizaje automático porque acuñó el término en 1959.

- 1965: Alexey (Oleksii) Ivakhnenko y Valentin Lapa desarrollaron el primer perceptrón multicapa. Ivakhnenko a menudo es considerado el padre del aprendizaje profundo (DL).

- 1967: Se concibe el algoritmo del vecino más cercano.

- 1979: El científico informático Kunihiko Fukushima publicó su trabajo sobre neocognitrón: una red jerárquica multicapa utilizada para detectar patrones. El neocognitrón también inspiró las redes neuronales convolucionales (CNNs).

- 1985: Terrence Sejnowski inventa NETtalk. Este programa aprende a pronunciar palabras (en inglés) de la misma manera que lo hacen los bebés.

- 1995: Tin Kam Ho introduce bosques de decisiones aleatorias en un artículo.

- 1997: Deep Blue, la computadora de ajedrez de IBM, vence a Garry Kasparov, el campeón mundial de ajedrez.

- 2000: El término aprendizaje profundo se mencionó por primera vez por el investigador de redes neuronales Igor Aizenberg.

- 2009: Fei-Fei Li lanzó ImageNet, una gran base de datos de imágenes utilizada extensamente para la investigación de reconocimiento de objetos visuales.

- 2011: El X Lab de Google desarrolló Google Brain, un algoritmo de inteligencia artificial. Más tarde ese año, IBM Watson venció a competidores humanos en el programa de concursos de trivia Jeopardy!.

- 2014: Ian Goodfellow y sus colegas desarrollaron una red generativa antagónica (GAN). El mismo año, Facebook desarrolló DeepFace, un sistema de reconocimiento facial de aprendizaje profundo que puede identificar rostros humanos en imágenes con una precisión de casi el 97.25%. Más tarde, Google presentó un sistema de aprendizaje automático a gran escala llamado Sibyl al público.

- 2015: AlphaGo se convierte en la primera IA en vencer a un jugador profesional en Go.

- 2020: Open AI anuncia GPT-3, un robusto algoritmo de procesamiento de lenguaje natural con la capacidad de generar texto similar al humano.

¿Quieres aprender más sobre Software de Inteligencia Artificial? Explora los productos de Inteligencia Artificial.

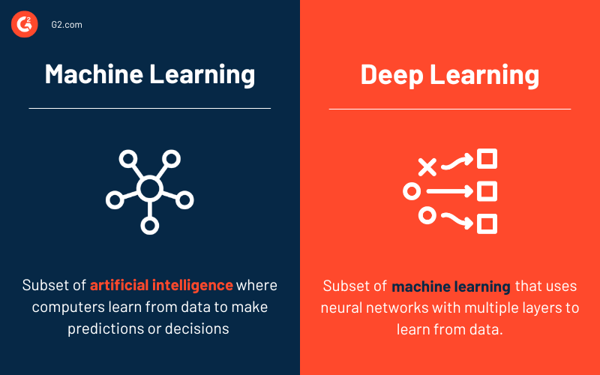

Aprendizaje automático vs. aprendizaje profundo

Si bien tanto el aprendizaje automático como el aprendizaje profundo son subconjuntos de la inteligencia artificial, difieren en su alcance y complejidad.

El aprendizaje automático (ML) implica entrenar modelos con datos para hacer predicciones o decisiones utilizando varias técnicas, como árboles de decisión, máquinas de vectores de soporte y k-vecinos más cercanos. En este enfoque, a menudo es necesaria la intervención humana para identificar características relevantes y asegurar que los modelos mejoren con el tiempo.

En contraste, el aprendizaje profundo (DL) es un subconjunto más avanzado del ML que utiliza redes neuronales artificiales inspiradas en el cerebro humano, que comprenden capas de nodos interconectados (neuronas). Los modelos de DL sobresalen en el procesamiento de grandes cantidades de datos y pueden identificar automáticamente características cruciales sin guía humana.

Por ejemplo, en tareas de reconocimiento de imágenes, el aprendizaje profundo puede detectar autónomamente bordes, formas y objetos complejos, mientras que los métodos tradicionales de ML generalmente requieren que los humanos especifiquen estas características de antemano.

Cómo funciona el aprendizaje automático

En su núcleo, los algoritmos de aprendizaje automático analizan e identifican patrones a partir de conjuntos de datos, luego usan esa información para hacer predicciones mejoradas sobre nuevos datos no vistos. Este proceso refleja cómo los humanos aprenden y mejoran. Cuando tomamos decisiones, a menudo nos basamos en experiencias pasadas para evaluar mejor nuevas situaciones. De manera similar, un modelo de aprendizaje automático examina datos históricos para hacer predicciones o decisiones informadas.

Para simplificar el concepto, imagina jugar al juego del dinosaurio en Google Chrome (el que aparece cuando no hay internet). El desafío es saltar sobre los cactus o agacharse bajo los pájaros. Un humano aprende esto a través de prueba y error, reconociendo rápidamente que necesitas evitar obstáculos para permanecer en el juego.

Una aplicación de aprendizaje automático aprendería de manera similar. Un desarrollador podría programar la aplicación para saltar cada vez que el T-Rex encuentre un área densa de píxeles oscuros, con la tasa de éxito de esa acción aumentando con el tiempo. Al encontrar más obstáculos y ajustarse en función de los resultados, la IA podría refinar sus predicciones sobre cuándo saltar o agacharse.

Tomemos otro ejemplo:

Considera esta secuencia:

3 → 9

4 → 16

5 → 25

Si te pidieran predecir el número que se empareja con 6, probablemente dirías 36. Hiciste esto al reconocer un patrón (cada número se eleva al cuadrado). Un modelo de aprendizaje automático funciona de la misma manera: analizando datos previos para hacer predicciones basadas en patrones.

En esencia, el aprendizaje automático es pura matemática. Cada algoritmo de aprendizaje automático se basa en funciones matemáticas que se ajustan a medida que aprende. Esto significa que el proceso de aprendizaje en sí está arraigado en las matemáticas, transformando datos en información procesable.

4 métodos de aprendizaje automático

Existen numerosos métodos de aprendizaje automático mediante los cuales los sistemas de IA pueden aprender de los datos. Estos métodos se categorizan según la naturaleza de los datos (etiquetados o no etiquetados) y los resultados que anticipas. Generalmente, hay cuatro tipos de aprendizaje automático: supervisado, no supervisado, semi-supervisado, y aprendizaje por refuerzo

1. Aprendizaje supervisado

El aprendizaje supervisado es un enfoque de aprendizaje automático en el que un científico de datos actúa como un tutor y entrena al sistema de IA alimentándolo con reglas básicas y conjuntos de datos etiquetados. Los conjuntos de datos incluirán datos de entrada etiquetados y resultados esperados. En este método de aprendizaje automático, se le dice explícitamente al sistema qué buscar en los datos de entrada.

En términos más simples, los algoritmos de aprendizaje supervisado aprenden por ejemplo. Tales ejemplos se refieren colectivamente como datos de entrenamiento. Una vez que un modelo de aprendizaje automático se entrena utilizando el conjunto de datos de entrenamiento, se le da el conjunto de datos de prueba para determinar la precisión del modelo.

El aprendizaje supervisado se puede clasificar además en dos tipos: clasificación y regresión.

2. Aprendizaje no supervisado

El aprendizaje no supervisado es una técnica de aprendizaje automático en la que el científico de datos deja que el sistema de IA aprenda observando. El conjunto de datos de entrenamiento contendrá solo los datos de entrada y no datos de salida correspondientes.

A diferencia del aprendizaje supervisado, el aprendizaje no supervisado requiere grandes cantidades de datos no etiquetados para observar, encontrar patrones y aprender. El aprendizaje no supervisado podría ser un objetivo en sí mismo, por ejemplo, descubrir patrones ocultos en conjuntos de datos o un método para el aprendizaje de características.

Los problemas de aprendizaje no supervisado generalmente se agrupan en problemas de agrupamiento y asociación.

3. Aprendizaje semi-supervisado

El aprendizaje semi-supervisado es una amalgama de aprendizaje supervisado y no supervisado. En este proceso de aprendizaje automático, el científico de datos entrena al sistema solo un poco para que obtenga una visión general de alto nivel.

Además, un pequeño porcentaje de los datos de entrenamiento estará etiquetado, y el resto no estará etiquetado. A diferencia del aprendizaje supervisado, este método de aprendizaje exige que el sistema aprenda las reglas y la estrategia observando patrones en el conjunto de datos.

El aprendizaje semi-supervisado es beneficioso cuando no tienes suficientes datos etiquetados o el proceso de etiquetado es costoso, pero deseas crear un modelo de aprendizaje automático preciso.

4. Aprendizaje por refuerzo

El aprendizaje por refuerzo (RL) es una técnica de aprendizaje que permite a un sistema de IA aprender en un entorno interactivo. Un programador utilizará un enfoque de recompensa-penalización para enseñar al sistema, permitiéndole aprender por prueba y error y recibir retroalimentación de sus propias acciones.

En pocas palabras, en el aprendizaje por refuerzo, el sistema de IA enfrenta una situación similar a un juego en la que debe maximizar la recompensa.

Aunque el programador define las reglas del juego, el individuo no proporciona ninguna pista sobre cómo resolver o ganar el juego. El sistema debe encontrar su camino realizando numerosos ensayos aleatorios y aprendiendo a mejorar con cada paso.

Casos de uso del aprendizaje automático

Los proyectos de aprendizaje automático han revolucionado casi todas las industrias que han experimentado una transformación digital. Aquí hay solo algunos de los muchos casos de uso impactantes de proyectos de aprendizaje automático en varios sectores.

Reconocimiento de imágenes

Las máquinas están mejorando en el procesamiento de imágenes. De hecho, los modelos de aprendizaje automático son mejores y más rápidos en reconocer y clasificar imágenes que los humanos.

Esta aplicación del aprendizaje automático se llama reconocimiento de imágenes o visión por computadora. Está impulsada por algoritmos de aprendizaje profundo y utiliza imágenes como datos de entrada. Lo más probable es que hayas visto esta hazaña en acción cuando subiste una foto en Facebook, y la aplicación sugirió etiquetar a tus amigos al reconocer sus rostros.

Software de gestión de relaciones con clientes (CRM)

El aprendizaje automático permite a las aplicaciones de CRM descifrar las preguntas del "por qué".

¿Por qué un producto específico supera al resto? ¿Por qué los clientes realizan una acción particular en el sitio web? ¿Por qué los clientes no están satisfechos con un producto?

Al analizar datos históricos recopilados por aplicaciones de CRM, los modelos de aprendizaje automático pueden ayudar a construir mejores estrategias de ventas e incluso predecir tendencias emergentes del mercado. El ML también puede encontrar medios para reducir las tasas de abandono, mejorar el valor de vida del cliente y ayudar a las empresas a mantenerse un paso adelante.

Junto con el análisis de datos, la automatización del marketing y el análisis predictivo, el aprendizaje automático otorga a las empresas la capacidad de estar disponibles 24/7 mediante su encarnación como chatbots.

Diagnóstico de pacientes

Es seguro decir que los registros médicos en papel son cosa del pasado. Muchos hospitales y clínicas han adoptado registros de salud electrónicos (EHRs), lo que hace que el almacenamiento de información del paciente sea más seguro y eficiente.

Dado que los EHRs convierten la información del paciente a un formato digital, la industria de la salud puede implementar el aprendizaje automático y erradicar procesos tediosos. Esto también significa que los médicos pueden analizar datos de pacientes en tiempo real e incluso predecir la posibilidad de brotes de enfermedades.

Además de mejorar la precisión del diagnóstico médico, los algoritmos de aprendizaje automático pueden ayudar a los médicos a detectar el cáncer de mama y predecir la tasa de progresión de una enfermedad.

Optimización de inventario

Si un material específico se almacena en exceso, puede que no se use antes de que se eche a perder. Por otro lado, si hay escasez, la cadena de suministro se verá afectada. La clave es mantener el inventario considerando la demanda del producto.

La demanda de un producto se puede predecir en función de datos históricos. Por ejemplo, el helado se vende con más frecuencia durante la temporada de verano (aunque no siempre y en todas partes). Sin embargo, numerosos otros factores afectan la demanda, incluyendo el día de la semana, la temperatura, los próximos días festivos y más.

Calcular tales factores micro y macro es prácticamente imposible para los humanos. No es sorprendente que procesar tales volúmenes masivos de datos sea una especialidad de las aplicaciones de aprendizaje automático.

Por ejemplo, al aprovechar la enorme base de datos de The Weather Company , IBM Watson descubrió que las ventas de yogur aumentan cuando el viento está por encima del promedio, y las ventas de autogás aumentan cuando la temperatura es más fría que el promedio.

Además, los coches autónomos, la previsión de la demanda, el reconocimiento de voz, los sistemas de recomendación y la detección de anomalías no habrían sido posibles sin el aprendizaje automático.

Cómo construir un modelo de aprendizaje automático

Crear un modelo de aprendizaje automático es como desarrollar un producto. Hay una fase de ideación, validación y prueba, por nombrar algunos procesos. Generalmente, construir un modelo de aprendizaje automático se puede desglosar en cinco pasos.

Recopilación y preparación del conjunto de datos de entrenamiento

En el ámbito del aprendizaje automático, nada es más importante que los datos de entrenamiento de calidad.

Como se mencionó anteriormente, el conjunto de datos de entrenamiento es una colección de puntos de datos. Estos puntos de datos ayudan al modelo a entender cómo abordar el problema que está destinado a resolver. Típicamente, el conjunto de datos de entrenamiento contiene imágenes, texto, video o audio.

El conjunto de datos de entrenamiento es similar a un libro de texto de matemáticas con problemas de ejemplo. Cuanto mayor sea el número de ejemplos, mejor. Junto con la cantidad, la calidad del conjunto de datos también importa, ya que el modelo necesita ser altamente preciso. El conjunto de datos de entrenamiento también debe reflejar las condiciones del mundo real en las que se utilizará el modelo.

El conjunto de datos de entrenamiento puede estar completamente etiquetado, no etiquetado o parcialmente etiquetado. Como se mencionó anteriormente, la naturaleza del conjunto de datos depende del método de aprendizaje automático que elijas.

De cualquier manera, el conjunto de datos de entrenamiento debe estar libre de datos duplicados. Un conjunto de datos de alta calidad pasará por numerosas etapas del proceso de limpieza y contendrá todos los atributos esenciales que deseas que el modelo aprenda.

Siempre ten en mente esta frase: basura entra, basura sale.

Elige un algoritmo

Un algoritmo es un procedimiento o método para resolver un problema. En el lenguaje del aprendizaje automático, un algoritmo es un procedimiento que se ejecuta en los datos para crear un modelo de aprendizaje automático. La regresión lineal, la regresión logística, los k-vecinos más cercanos (KNN) y Naive Bayes son algunos de los algoritmos de aprendizaje automático populares.

Elegir un algoritmo depende del problema que deseas resolver, el tipo de datos (etiquetados o no etiquetados) y la cantidad de datos disponibles.

Si estás usando datos etiquetados, puedes considerar los siguientes algoritmos:

- Árboles de decisión

- Regresión lineal

- Regresión logística

- Máquina de vectores de soporte (SVM)

- Bosque aleatorio

Si estás usando datos no etiquetados, puedes considerar los siguientes algoritmos:

- Algoritmo de agrupamiento K-means

- Algoritmo Apriori

- Descomposición en valores singulares

- Redes neuronales

Además, si deseas entrenar el modelo para hacer predicciones, elige el aprendizaje supervisado. Si deseas entrenar el modelo para encontrar patrones o dividir datos en grupos, opta por el aprendizaje no supervisado.

Entrena el algoritmo

En esta fase, el algoritmo pasa por numerosas iteraciones. Después de cada iteración, los pesos y sesgos dentro del algoritmo se ajustan comparando la salida con los resultados esperados. El proceso continúa hasta que el algoritmo se vuelve preciso, lo que es el modelo de aprendizaje automático.

Valida el modelo

Para muchos, el conjunto de datos de validación es sinónimo del conjunto de datos de prueba. En resumen, es un conjunto de datos que no se utiliza durante la fase de entrenamiento y se introduce al modelo por primera vez. El conjunto de datos de validación es crítico para evaluar la precisión del modelo y entender si sufre de sobreajuste, una optimización incorrecta de un modelo cuando se ajusta demasiado a su conjunto de datos de entrenamiento.

Si la precisión del modelo es menor o igual al 50%, es poco probable que sea útil para aplicaciones del mundo real. Idealmente, el modelo debe tener una precisión del 90% o más.

Prueba el modelo

Una vez que el modelo está entrenado y validado, necesita ser probado usando datos del mundo real para verificar su precisión. Este paso podría hacer sudar al científico de datos, ya que el modelo será probado en un conjunto de datos más grande, a diferencia de la fase de entrenamiento o validación.

En un sentido más simple, la fase de prueba te permite verificar qué tan bien ha aprendido el modelo a realizar la tarea específica. También es la fase donde puedes determinar si el modelo funcionará en un conjunto de datos más grande.

El modelo mejora con el tiempo y con acceso a conjuntos de datos más nuevos. Por ejemplo, el filtro de spam de tu bandeja de entrada de correo electrónico mejora periódicamente cuando reportas mensajes particulares como spam y falsos positivos como no spam.

Mejor software de aprendizaje automático

Como se mencionó anteriormente, los algoritmos de aprendizaje automático son capaces de hacer predicciones o decisiones basadas en datos. Estos algoritmos otorgan a las aplicaciones la capacidad de ofrecer automatización y características de IA. Curiosamente, la mayoría de los usuarios finales no son conscientes del uso de algoritmos de aprendizaje automático en tales aplicaciones inteligentes.

Para calificar para la inclusión en la categoría de aprendizaje automático, un producto debe:

- Ofrecer un producto o algoritmo capaz de aprender y mejorar aprovechando los datos

- Ser la fuente de habilidades de aprendizaje inteligente en aplicaciones de software

- Ser capaz de utilizar entradas de datos de diferentes fuentes de datos

- Tener la capacidad de producir una salida que resuelva un problema particular basado en los datos aprendidos

* A continuación se presentan los cinco principales software de aprendizaje automático del Informe Grid® de Otoño 2024 de G2. Algunas reseñas pueden estar editadas para mayor claridad.

1. Vertex AI

Vertex AI es una plataforma unificada que simplifica el desarrollo y despliegue de modelos de ML. Ofrece un conjunto completo de herramientas y servicios, incluyendo preparación de datos, entrenamiento de modelos, evaluación y despliegue, lo que facilita a los desarrolladores y científicos de datos construir y gestionar aplicaciones de ML.

Lo que más les gusta a los usuarios:

"Para un proyecto personal, decidí construir un chatbot de IA conversacional destinado a hacer que la conversación se sintiera más humana. Inicialmente usé Dialogflow, pero las respuestas no sonaban naturales. Tuve problemas para organizar conversaciones, planificar flujos de usuario y manejar errores.

Luego, encontré el Constructor de Agentes de Vertex AI (anteriormente llamado Búsqueda y Conversaciones de Vertex AI). Usar la API del Constructor de Agentes me ahorró mucho tiempo en problemas de autenticación y acceso. Al final, pude crear un chatbot que suena natural, usando una base de conocimiento que construí con LLM y RAG."

- Reseña de Vertex AI, Tejashri P.

Lo que no les gusta a los usuarios:

"Falta documentación detallada para algunas características avanzadas y casos de uso más complejos. Además, dependiendo de la carga de trabajo y la configuración, los tiempos de entrenamiento a veces pueden parecer más lentos que al usar hardware dedicado para ejecutar modelos."

- Reseña de Vertex AI, Manoj P.

2. Amazon Forecast

Amazon Forecast es un servicio de aprendizaje automático completamente gestionado que utiliza algoritmos avanzados para generar pronósticos precisos para datos de series temporales. Aprovecha la misma tecnología utilizada por Amazon.com para predecir tendencias futuras para millones de productos. Al predecir con precisión la demanda futura de productos y servicios, las empresas pueden optimizar el inventario, reducir el desperdicio y mejorar la planificación.

Lo que más les gusta a los usuarios:

"Amazon Forecast es un servicio de análisis predictivo fácil de usar que maneja automáticamente grandes volúmenes de datos, lo que lo hace ideal para una variedad de necesidades de pronóstico. Con sus algoritmos avanzados, genera pronósticos altamente precisos, ayudando a las empresas a tomar decisiones informadas basadas en información confiable."

- Reseña de Amazon Forecast, Annette J.

Lo que no les gusta a los usuarios:

"La precisión y efectividad de los pronósticos generados por Amazon Forecast dependen en gran medida de la calidad y relevancia de los datos de entrada. Si los datos históricos utilizados para el entrenamiento incluyen anomalías, valores atípicos u otros problemas de calidad, puede afectar negativamente la precisión del pronóstico."

- Reseña de Amazon Forecast, Saurabh M.

3. Google Cloud TPU

Google Cloud TPU es un circuito integrado específico de aplicación (ASIC) de aprendizaje automático diseñado para ejecutar modelos de aprendizaje automático con servicios de IA en Google Cloud. Ofrece más de 100 petaflops de rendimiento en un solo pod, lo que es suficiente potencia computacional para necesidades empresariales y de investigación.

Lo que más les gusta a los usuarios:

"Me encanta el hecho de que pudimos construir un servicio de IA de última generación orientado a la seguridad de la red gracias a la ejecución óptima de los modelos de aprendizaje automático de vanguardia. El poder de Google Cloud TPU no tiene comparación: hasta 11.5 petaflops y 4 TB HBM. Lo mejor de todo, la interfaz de Google Cloud Platform es sencilla y fácil de usar."

- Reseña de Google Cloud TPU, Isabelle F.

Lo que no les gusta a los usuarios:

"Desearía que hubiera integración con procesadores de texto."

- Reseña de Google Cloud TPU, Kevin C.

4. Jarvis

Jarvis de NVIDIA es una plataforma de aprendizaje automático que proporciona una interfaz fácil de usar para construir y desplegar modelos de ML. Simplifica el proceso de preparación de datos, selección de modelos, entrenamiento y evaluación. Jarvis ML ofrece modelos preconstruidos para tareas comunes como clasificación de imágenes, procesamiento de lenguaje natural y pronóstico de series temporales.

Lo que más les gusta a los usuarios:

"Jarvis es similar a otras tecnologías de IA, pero lo que más aprecio es su función de entrada por comando de voz, que mejora la productividad. Además, proporciona sugerencias de contenido creativo para creadores de blogs, lo que lo convierte en una herramienta valiosa para la generación de contenido."

- Reseña de Jarvis, Akshit N.

Lo que no les gusta a los usuarios:

"La función de voz es efectiva, pero los usuarios acostumbrados a Google Voice pueden encontrar la fluidez de entrada a salida menos satisfactoria en comparación con otras opciones de voz. Aunque la interfaz de usuario parece visualmente atractiva, es esencial que la API configurada detrás de la interfaz también funcione bien."

- Reseña de Jarvis, Adithya K.

5. Aerosolve

Aerosolve es una plataforma de software de aprendizaje automático diseñada principalmente para aplicaciones de análisis predictivo y ciencia de datos. Se destaca por su facilidad de uso, permitiendo a los usuarios construir modelos complejos sin requerir habilidades extensas de programación.

Lo que más les gusta a los usuarios:

"Estoy impresionado por sus capacidades avanzadas. Es muy fácil de usar, con una implementación fluida e integración sencilla. Además, el soporte al cliente es decente, lo que hace que la experiencia general sea positiva."

- Reseña de Aerosolve, Rahul S.

Lo que no les gusta a los usuarios:

"Aerosolve se queda corto en áreas como las capacidades de procesamiento de imágenes."

- Reseña de Aerosolve, Aurelija A.

¡La IA es el cerebro, el ML es el músculo!

El aprendizaje automático es el músculo que permite a la IA aprender, adaptarse y realizar tareas complejas. Desde la ciencia de datos hasta la ingeniería de IA, el aprendizaje automático se está utilizando en todas partes.

A medida que el aprendizaje automático continúa evolucionando, podemos esperar ver aplicaciones aún más innovadoras. Desde coches autónomos hasta medicina personalizada, el aprendizaje automático está transformando industrias y mejorando nuestras vidas.

Sin embargo, con este progreso viene la responsabilidad de asegurar que estas tecnologías se desarrollen y utilicen de manera ética. Al abordar preocupaciones como la privacidad de los datos y el sesgo, podemos aprovechar el poder de la IA a través del aprendizaje automático y crear un futuro más personalizado, inclusivo e inteligente.

Descubre estadísticas de aprendizaje automático que darán forma al futuro.

Este artículo fue publicado originalmente en 2021. Ha sido actualizado con nueva información.

Amal Joby

Amal is a Research Analyst at G2 researching the cybersecurity, blockchain, and machine learning space. He's fascinated by the human mind and hopes to decipher it in its entirety one day. In his free time, you can find him reading books, obsessing over sci-fi movies, or fighting the urge to have a slice of pizza.